Административна информация

| Дял | Обслужващи производствени модели |

| Продължителност | 60 минути |

| Модул | Б |

| Вид на урока | Урок |

| Фокус | Практически — Организационен ИИ |

| Тема | Модел на производство на сгради API |

Ключови думи

машинно самообучение, контейнери,

Учебни цели

- Запознаване с контейнеризацията

- Обучение TFX обслужване

- Възможност за прилагане на сервиране локално и на Azure Container Instances

Очаквана подготовка

Обучение на събития, които трябва да бъдат завършени преди

Няма.

Задължително за студентите

- Инсталирайте WSL 2 преди инсталирането на Docker

- Можете да използвате опцията Windows Hyper-V, но това не поддържа графичния процесор

- Ще трябва да инсталирате Ubuntu (или други подходящи варианти), с командата WSL CLI wsl -инсталиране -d ubuntu

- За някои машини WSL също ще трябва да се актуализира с командата wsl -update ( Повече информация за тази актуализация)

- Ще трябва да инсталирате най-новите NVIDIA/CUDA драйвери

- Инсталиране на Docker за Windows: https://docs.docker.com/desktop/install/windows-install/

- Създаване на Azure акаунт с достъп за създаване на Azure Container Instances (ACI)

Незадължително за студенти

Референции и фон за студенти

- Адития Хосла, Нитянанда Джаядевапракаш, Бангпенг Яо и Ли Фей-Фей. Нов набор от данни за категоризация на изящни изображения. Първа работна среща по изящна визуална категоризация (FGVC), Конференция на IEEE за компютърна визия и разпознаване на модели (CVPR), 2011 г.

Препоръчва се за учители

- Изпълнявайте задачите, изброени като задължителни и незадължителни за учениците.

Материали за уроци

Инструкции за учители

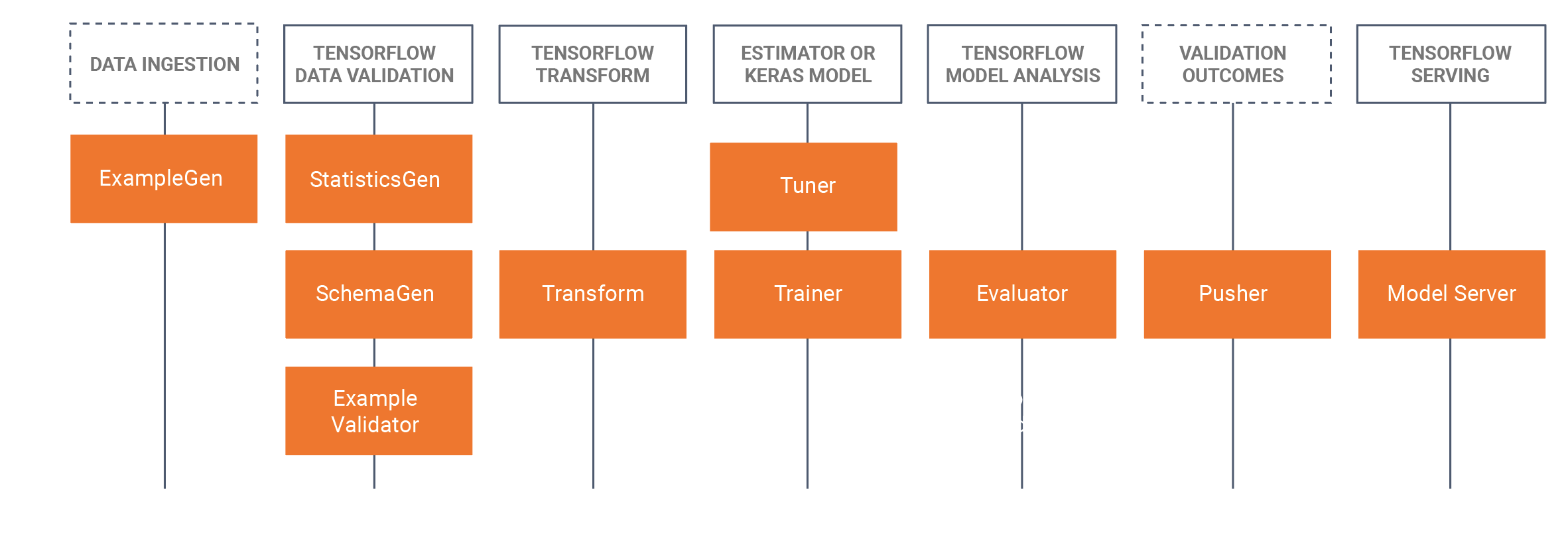

Производствени модели, използващи TFX Serving

- Този урок ще запознае студентите да вземат разработен обучен модел, който е разработен в Jupyter Notebook (използвайки Tensorflow 2.x и Keras) и запазване на модела в Tensorflow формат. Урокът ще започне с разработване на основен CNN за идентифициране на хляба на куче. След това ще запазим модела като модел Tensorflow. След това урокът ще използва TFX (Tensorflow Extended https://www.tensorflow.org/tfx/serving/docker)подход за MLOps, където ще се съсредоточим в този урок за TRX обслужващ компонент, който е изграждане на спокойни APIs за използване/запитване в производствени среди. За да направим това, ще изградим Docker TFX обслужващо изображение и ще разположим това изображение:

- Локално (местно домакин)

- Чрез Azure Container Instances (ACI), където може да се търси публичен IP адрес

- Необходими са предварителни инсталации, моля, вижте задължителната подготовка за учениците по-долу.

- Наборът от данни е наборът от данни за кучета от Станфорд, в който използваме два класа кучета, Джак Ръсел и Rhodesian Ridgeback, пълният набор от данни може да бъде намерен тук, Ние също предоставихме подмножеството, използвано в този урок в раздела за набор от данни по-долу.

- Ние също така предоставихме всички команди на Docker CLI в долната част на този урок WIKI страница.

Описание/времеви график

| Продължителност (минимум) | Описание |

|---|---|

| 20 | Проблем 1: Изграждане на CNN модел, използвайки подмножество от данни за кучета от Станфорд, запазвайки този модел като модел Tensorflow |

| 10 | Проблем 2: Разгръщане на модела Tensorflow на API на място (използване на Docker) и търсене на модела |

| 20 | Проблем 3: Разполагане на модела Tensorflow в API на Rest с помощта на Azure Container Instances (ACI) (използване на Docker) и търсене на модела |

| 10 | Обобщение на процеса на преминаване напред |

Docker CLI команди

Следните команди за интерфейс на командния ред се използват в този урок, за да стартирате моделите.

Бягайте на местно ниво

Стъпка 1: Издърпайте тензорфлока

Docker дърпа tensorflow/serving: Lastst-gpu

Стъпка 2: Стартирайте изображението

Docker run -gpus all -p 8501:8501 -name tfserving_classifier --mount type=bind,source=c:\production\,target=/models/img_classifier -e MODEL_NAME=img_classifier -t tensorflow/serving: lastst-gpu

или без GPU

Docker run -p 8501:8501 -name tfserving_classifier --mount type=bind,source=c:\production\,target=/models/img_classifier -e MODEL_NAME=img_classifier -t tensorflow/serving: lastst-gpu

Стартирайте на Azure с помощта на ACI

Стъпка 1: Промяна на местното изображение, за да има включен модел

Docker run -d -name service_base tensorflow/serving: lastst-gpu Docker cp c:\production\ service_base:/models/img_classifier Docker ps -a # за да получите ID Docker commit -change „ENV MODEL_NAME img_classifier“ &id отива тук> tensorflow_dogs_gpu Docker Убийте сервиране_base

Стъпка 2: Разгърнете изображението в Azure ACI

Docker login лазура Docker контекст създаде aci изтриване Docker контекст използване изтриване Docker run -p 8501:8501 kquille/tensorflow_dogs_gpu:kq

Стъпка 3 Достъп до регистрационните файлове на ACI, IP адреса и след това спрете и премахнете услугата ACI ====

Docker logs jolly-ride Docker ps Докър спри веселата езда Docker rm jolly-ride

Потвърждения

Кийт Кийл (TU Dublin, Tallaght Campus)

Магистърската програма по ИИ, насочена към човека, беше съфинансирана от Механизма за свързване на Европа на Европейския съюз под формата на безвъзмездни средства № CEF-TC-2020—1 Digital Skills 2020-EU-IA-0068.